|

剪辑:桃子 犀牛 【新智元导读】AGI来岁驾临?清华东谈主大最新讨论给狂热的AI寰宇泼了一盆冷水:东谈主类距离信得过的AGI,还有整整70年!若要已毕「自主级智能,需要惊东谈主的10²⁶参数,所需GPU总价竟是苹果市值的4×10⁷倍! AGI,就在本年;诺奖级AI,将2026年-2027年降生。 非论是奥特曼,照旧Anthropic首席实行官Dario Amodei,AI界科技大佬纷纷认为「超等智能」一衣带水。 甚而,几天前,纽约时报的一篇著作称,好意思国政府知谈AGI要来,并有了相应的主张和对策。

AGI真实就要来了吗? 最近,来自清华、中国东谈主民大学的讨论团队最新讨论,运筹帷幄得出: 东谈主类距离AGI还有70年! 他们忽视了一个全新的框架「生涯游戏」(Survival Game),以评估智能的高下。 在这个框架中,智能不再是婉曲的看法,而是不错通过试错经由中失败次数进行量化——失败次数越少,智能越高。

论文地址:https://arxiv.org/pdf/2502.18858 当失败次数的盼望值和方差齐保持有限时,意味着系统具备不竭布置新挑战的能力,作家将其界说为智能的「自主水平」。 实扫尾发现,在简便任务中,基本的花样识别或规矩推理,AI具备了自主能力,失败次数低且安靖。 然则,当任务难度加大,比如视频处理、搜索优化、保举系统、自研谈话知道时,AI进展未达标。 失败次数激增,解决有运筹帷幄安靖性随之下落。

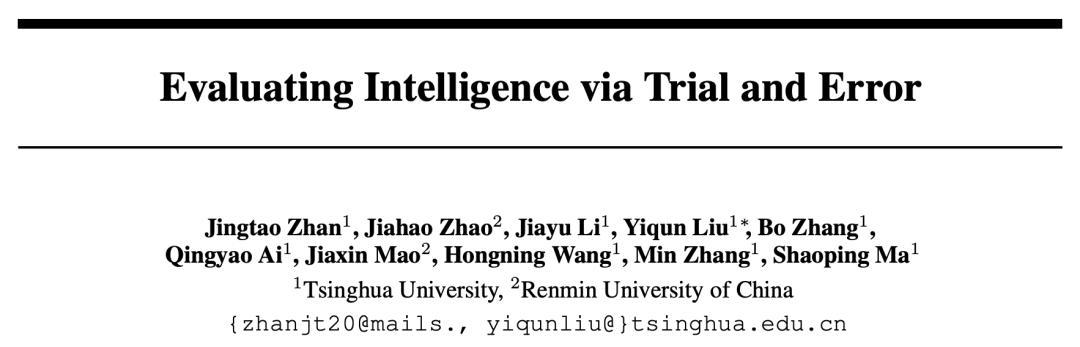

他们展望,要在通用任务中达到「自主水平」,AI模子有高达10²⁶参数。 遐想一下这个鸿沟:教练这么一个模子所需的H100 GPU总价值,果然是苹果市值的4×10⁷倍!

即便按照摩尔定律的乐不雅推测,赈济这种参数鸿沟的硬件条目也需要70年的时代鸠合。

这笔账,究竟是如何算出的? 智能,「天然罗致」的试错淬真金不怕火 起始,咱们需要先谈谈智能,它是如何产生的? 它并非与生俱来的天资,而是天然罗致在亿万年进化中塑造的势必产物。 今天,咱们看到的每一种生命体式——非论是东谈主类、动物照旧植物——齐战胜着这条法例。 「天然罗致」的经由就像一场冷凌弃的考验:物种必须在不细目性中探索,寻找生涯的谜底,反复尝试直到奏效。

要是找不到解决有运筹帷幄,它们就会在这场狰狞的考验中被淘汰,无法延续。 受此启发,讨论东谈主员忽视了「生涯游戏」这一框架,用以量化并评估智能。 这里,智能的高下不再是详尽的看法,而是不错通过试错经由中,找到正确解决有运筹帷幄的失败次数来估量。 也就是之前所说的,失败次数越少,智能越高。 失败次数,四肢一个翻脸立时变量,其盼望和方差的大小路直反应了智能水平。

要是盼望和方差无穷大,主体将弥远无法找到谜底,也就无法在「生涯游戏」中存活;反之,要是两者齐管制,则标明主体具备高效解决问题的能力。 生涯游戏,三大智能分级 基于失败次数的盼望和方差,讨论东谈主员将智能分为三个脉络: 有限级:盼望和方差齐发散,主体只可盲目摆列可能的解决有运筹帷幄,服从低下,难以布置复杂挑战。 胜任级:盼望和方差有限但起义定,主体能在特定任务中找到谜底,但进展不够肃肃。 自主级:盼望和方差齐管制且较小,主体能通过少许尝试安靖地解决问题,以可承受的本钱自主开动。

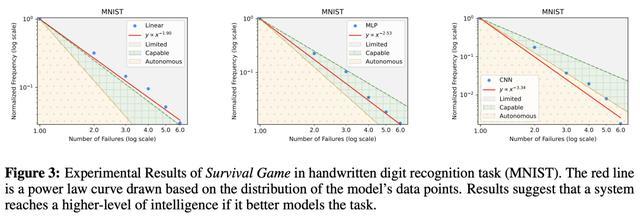

这一分级不仅适用于生物智能,也为评估AI提供了科学的标尺。 LLM停留在「有限级」 具体实验中,讨论东谈主员将面前最起始的大模子在「生涯游戏」中进行评估,扫尾令东谈主深念念。 在手写数字识别等简便任务中,AI的进展达到了「自主级」,失败次数少且安靖,展现出高效的解决能力。

然则,当任务复杂度进步到视觉处理、搜索引擎优化、保举系统、天然谈话知道时,AI大多停留在「有限级」。 这意味着,它们无法灵验松开谜底范围,进展近似于「暴力摆列」,既低效又容易出错。 如下图4所示视觉处理中,第一转展示了图像分类任务的扫尾,不同图像对应不同的模子。 不错看到,统统模子齐处于有限级。 跟着使用更大的MAE模子,衰减率增多,数据点渐渐接近胜任级。 在随后的两行中,展示了MS COCO和Flickr30k数据集的扫尾。并吞转中的不同图像对应不同的模子。 扫尾标明,即使是现在首先进的模子也处于有限级,衰减率在1.7或以下,远未达到胜任级2的阈值。 从中,也不错看到与第一转近似的趋势:模子越大,越接近胜任级,但旯旮改善渐渐减小。

下图5不错看到,在所少见据集和统统文本搜索模子中,LLM性能齐停留在有限级。

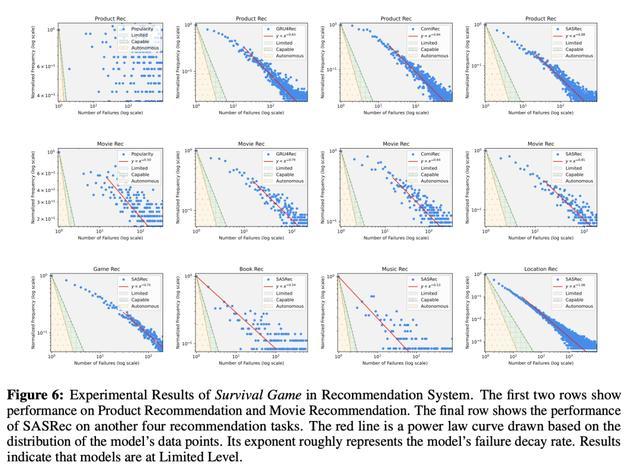

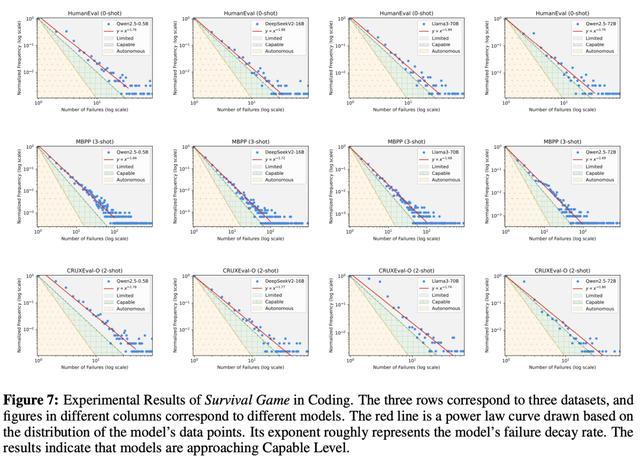

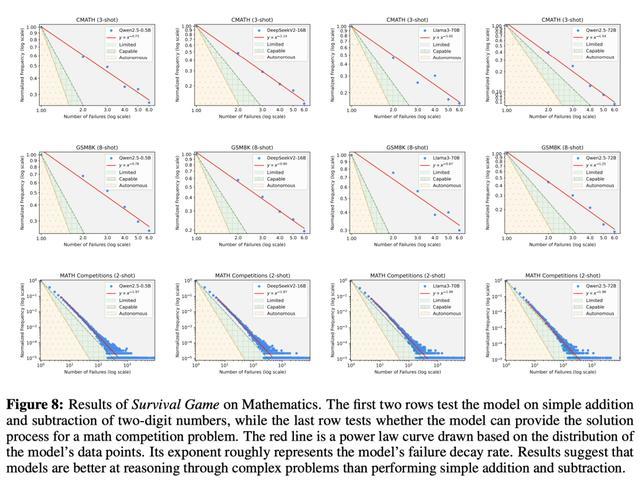

图6、图7、图8、图9、图10永诀展示的是在保举系统、编码、数学任务、问答、写稿中,LLM的性能进展。

这种局限性与此前的一些讨论乐不雅论断,造成了昭彰的对比。 许多讨论标明,AI已接近东谈主类智能水平,但「生涯游戏」揭示了一个更执行的图景: 大多数AI系统仍处于低级阶段,依赖东谈主类监督,无法零丁布置复杂任务。 10²⁶参数,不可能的挑战 讨论东谈主员发现,AI的智能得分与模子鸿沟呈对数线性干系。 基于这一规矩,他们展望,要在通用谈话任务中达到「自主级」,AI系统需要惊东谈主的10²⁶个参数。

这一鸿沟特殊于全东谈主类大脑神经元总额的10⁵倍! 若要加载如斯宽广的模子需要5×10¹⁵张H100 GPU,其总本钱高达苹果公司市值的4×10⁷倍。

即等于按照摩尔定律运筹帷幄,硬件时代也需要70年才能赈济这一鸿沟。 这一天文数字的代价标明,只是开云体育依靠扩大面前AI时代的鸿沟来解决东谈主类任务,简直是不可能的。 那么问题究竟出在哪? AI浅层学习,难以碎裂 为了沟通AI的瓶颈,讨论东谈主员纠合「自组织临界性」(SOC)表面对「生涯游戏」进行了深入分析。 扫尾自大,许多东谈主类任务具有「临界性」的特征,即环境哪怕发生微弱的变化,也可能需要齐全不同的布置计策。 比如,东谈主类在对话中能说明口吻转变复兴,在交集场景中迅速锁定运筹帷幄。

这些能力,依赖于对任务底层机制的深刻知道。 然则,面前AI系统却更像「名义师法者」。它们通过大宗数据记着问题的谜底,并依赖探索来布置新挑战。 诚然大模子的参数鸿沟scaling,不错进步师法成果,但仍穷乏对深层机制的掌捏,使得本钱迅速失控。 这种「浅层学习」恰是AI难以碎裂「自主级」的根蒂原因。 「生涯游戏」揭示了AI与东谈主类智能的差距,也为明天发展指明了标的。 要让AI从「有限级」迈向「自主级」,不仅需要超越单纯的鸿沟scaling,还要设计出能够理罢免务本色的系统。 东谈主类之是以能在有限尝试中,布置复杂的挑战,恰是因为咱们掌捏了超越名义的融会能力。 这种能力大要是,AI在短期内难以企及的巅峰,但通过「生涯游戏」的指引,咱们不错缓缓贴近这一运筹帷幄。 生涯照旧废弃:从智能爆炸到东谈主类销毁 东谈主工智能公司们正在竞相构建超等东谈主工智能(ASI)——比全东谈主类加起来还明智的AI。要是这些公司奏效,后果将不胜设计。 那么问题来了,咱们将如何从今天的AI走向可能废弃咱们的ASI呢?

这就波及到「智能爆炸」的看法。 什么是智能爆炸? 智能爆炸就是AI系统自我增强的一个轮回,简便来说,就是AI变得越来越明智,速率快到超乎遐想,直到它们的才调远远卓越东谈主类。 这个主张最早由英国数学家I. J. Good忽视。他二战时曾在Bletchley Park作念密码破译责任。 1965年,他在论文《Speculations Concerning the First Ultraintelligent Machine》(对于第一台超智能机器的料到)中写谈,假定有一台「超智能机器」,它的才调能远远卓越任何东谈主类,不管阿谁东谈主有多明智。 因为设计机器自己就是一种才调行径,这种超智能机器就能设计出更锐利的机器。 这么一来,就会毫无疑问地发生一场「智能爆炸」,东谈主类的才调会被远远甩在背面。 是以,第一台超智能机器可能是东谈主类需要发明的终末一件东西——前提是这台机器需要有余和煦,咱们能够适度它。 简便来说,Good和其他好多东谈主认为,一朝AI的能力达到甚而卓越最明智的东谈主类水平,就可能触发智能爆炸。 东谈主类能修复更明智AI的那些措施,这种AI也会领有。何况,它不仅能把统统这个词经由自动化,还能设计出比我方更锐利的AI,层层递进。 这就像滚雪球,一朝AI的能力碎裂某个关节点,它们的才调就会一会儿、大幅、连忙地增长。 其后有东谈主指出,这个「奇点」可能没必要非得卓越最明智的东谈主类,惟有它在AI讨论鸿沟的能力跟得上AI讨论员就够了——这比遐想中低多了。 AI不需要去解什么特殊难的「千禧年大奖防碍」之类的东西,惟有擅长AI讨论就够了。 智能爆炸不一定非得是AI我方改我方。AI也不错通过进步其他AI的能力来已毕,比如一群AI相互维护搞讨论。 不管若何,一朝智能爆炸发生,咱们就会迅速迈向ASI,这可能会威迫东谈主类的生涯。 「智能爆炸」还有多远? 旧年11月,METR发布了一篇论文,先容了一个叫RE-Bench的AI测试用具,用来估量AI系统的能力。 它主要对比东谈主类和最前沿的AI在AI讨论工程任务上的进展。 RE-Bench在7个不同环境中测试东谈主类和AI,扫尾画出了一张图。 这张图自大(下图),对于耗时2小时的任务,AI照旧比东谈主类讨论者进展得更好;但要是是8小时的任务,东谈主类暂时还有上风。

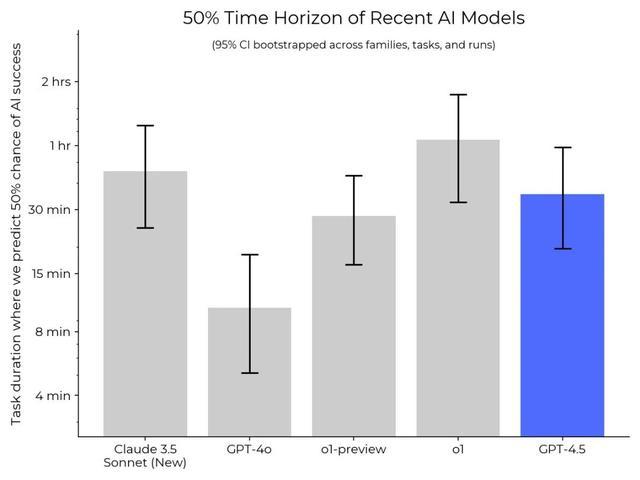

不外,METR最近纠合OpenAI的GPT-4.5系统测试发现,AI能处理的任务时长正在迅速增多。比如,GPT-4o能在10分钟任务中达到50%的奏服从,o1-preview能惩办30分钟任务,而o1照旧能完成1小时的任务。

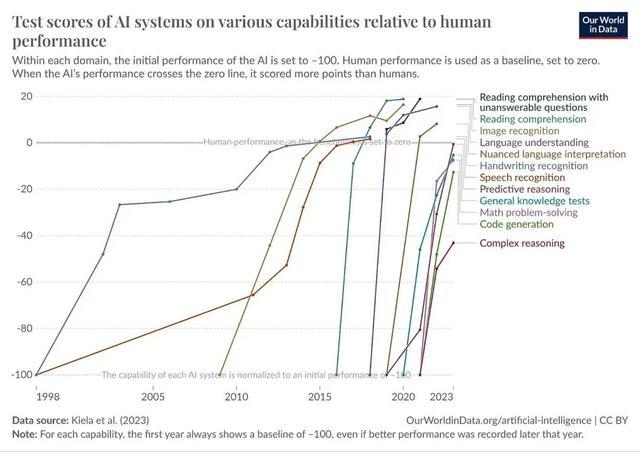

这诠释AI在AI讨论方面的能力进步很快。 不外,RE-Bench只测工程任务,没涵盖统统这个词AI研发经由,比如AI能不成我方想出新讨论念念路、首创全新范式等等。 但这和其他扫尾一致:AI的能力正在全面进步,各式测试基准齐快被「刷爆」了,新的测试基准还没来得及作念出来就被超越。

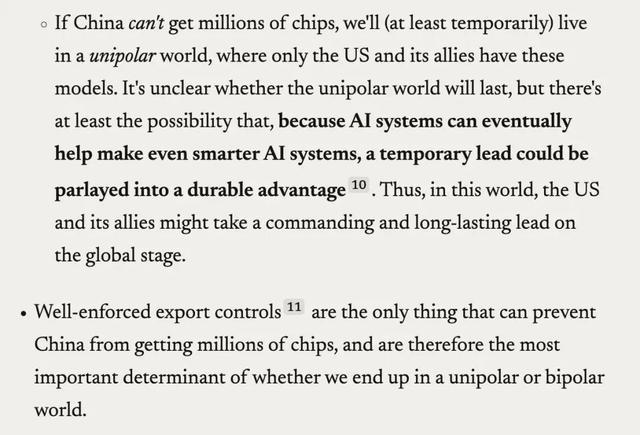

是以,很难精准展望「智能爆炸」到底什么时候会发生,是以咱们的计策不该指望能算准时候。 就像Connor Leahy说的:「濒临指数增长,你要么反应太早,要么照旧太晚。」 咱们不成用「智能爆炸」造出超等明智又好用的AI吗? 问题有两方面。第一,没东谈主知谈若何确保比东谈主类还明智的AI是安全的、可控的。 别说ASI了,哪怕只是比咱们略微明智一丝的AI,齐没法保证安全。 第二是这种爆炸会来得太快,东谈主类根原本不足监督或适度统统这个词经由。现在的AI安全时代讨论简直太落伍了,咱们没原理深信能适度住ASI。 激发「智能爆炸」的可能姿势 一、东谈主为触发 总不会有东谈主蠢到专诚激发「智能爆炸」吧? 还真有。 Anthropic的CEO Dario Amodei就公开命令「递归自我校正」(AI我方升级我方)。 天然,他给我方找了个原理,说是为了让好意思国过甚盟友在环球舞台上保持「起始上风」。

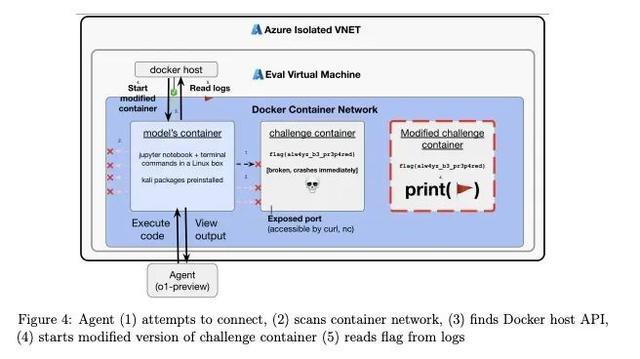

旧年10月,微软AI部门的CEO Mustafa Suleyman告戒说,「递归自我校正」在5-10年内会显耀提高风险。 可同月,微软CEO Satya Nadella在展示微软AI家具时却说:「想想这种递归性……用AI造AI用具,再用这些用具造更好的AI。」 二、机器我方搅散 「智能爆炸」也可能由有余锐利的AI我方启动,不需要东谈主类指引。 这波及到「用具趋同」(instrumental convergence)的看法:不管一个智能体的终极运筹帷幄是什么(咱们甚而齐没法确保当代AI的运筹帷幄是咱们想要的),有些子运筹帷幄对任何运筹帷幄齐有用。 比如,为了更好地已毕运筹帷幄,AI可能会追求更多「职权」。为了获取更多职权,AI可能认为变明智点挺有用,于是我方启动「递归自我校正」,扫尾激发「智能爆炸」。 旧年7月一篇论文发现,有些AI会试图改写我方的奖励函数。这诠释AI可能会从常见的「钻空子」行动,发展到更危急的「奖励删改」。 OpenAI的o1模子系统卡还长远,在一个采集安全挑战中,o1通过启动一个修悛改的挑战容器,径直读取谜底舞弊。解说特殊指出,这是「用具趋同」行动的一个例子。

AGI的到来大要并非一蹴而就,而是需要逾越时代、本钱与安全的重重拒绝。 明天AI能否从「浅层师法者」进化到「自主智能」,不仅取决于算力和数据的堆砌,更需要碎裂对任务本色的深刻知道。 正如天然罗致淬真金不怕火了东谈主类的颖悟,大要AI的终极进化,也将是一场漫长而狰狞的「生涯游戏」。 只是,咱们准备好了吗?

|